人工智能基础软件开发 当单纯的AI遇见复杂的人性

在技术飞速发展的今天,“人工智能很单纯,复杂的是人”这句话常常被提及,它精准地捕捉了AI技术开发与应用中的核心悖论。人工智能的基础软件开发,正是在这种张力中不断演进的领域。它一方面追求算法的纯粹、逻辑的严谨与效率的极致;另一方面,又无可避免地被人类的意图、偏见、伦理困境和社会需求所塑造和复杂化。

一、AI的“单纯”:源于确定性的根基

人工智能,尤其是其底层软件与算法,本质上是数学与逻辑的产物。它的“单纯”体现在几个方面:

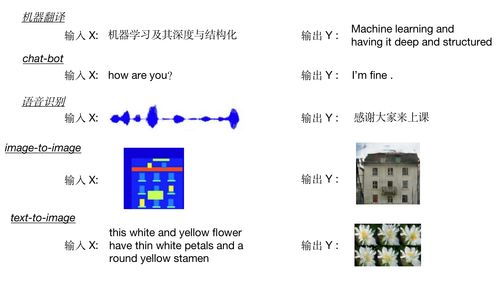

- 目标明确:无论是图像识别、自然语言处理还是决策推荐,AI模型在训练阶段的目标函数通常是清晰、可量化的(如准确率、损失函数最小值)。它纯粹地向着优化这个目标前进。

- 规则驱动:其行为完全由代码、数据和训练所得的参数决定,没有主观意识、情感波动或隐秘动机。给它相同的输入,在相同环境下,理论上会得到稳定可复现的输出。

- 无道德直觉:AI本身没有善恶观念。它无法理解其预测或决策可能蕴含的伦理意义,除非这种考量被开发者 explicitly(明确地)设计进目标或约束中。

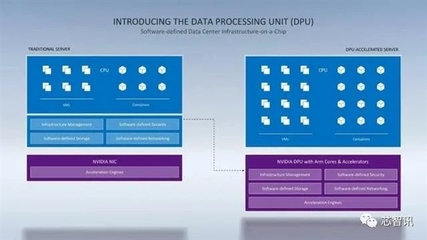

基础软件开发的核心任务,如框架设计(TensorFlow, PyTorch)、算法实现、算力优化和系统集成,正是为了构建和支撑这种高效、稳定且可扩展的“单纯”能力。开发者如同在打造一件精密乐器,追求的是响应准确、音色纯净。

二、人的“复杂”:注入价值与偏见的源头

这件“乐器”演奏什么曲子、如何演奏,以及演奏的效果,却完全掌握在复杂的人类手中。人的复杂性深刻渗透于AI基础软件开发的各个环节:

- 数据之镜:AI通过学习数据来认知世界。而训练数据由人类产生和选择,不可避免地反映了人类社会现有的偏见、不平等和历史遗留问题。基础软件工具虽然提供了数据处理管道,但选择收集哪些数据、如何标注数据,却充满主观判断和价值取向。

- 目标设定之重:开发者决定AI优化什么目标。是单纯追求点击率最大化,还是在推荐算法中融入多样性、公平性?这个看似技术性的选择,实质上是价值判断。一个“单纯”追求利润最大化的算法,可能导致信息茧房或歧视性定价。

- 应用场景之变:同样的图像识别技术,可用于医疗诊断挽救生命,也可用于大规模监控侵蚀隐私。基础软件提供了能力,但其部署和使用的意图,取决于组织与个人的决策,涉及复杂的法律、伦理和利益权衡。

- 解释与问责之困:即便开发出性能卓越的模型,其“黑箱”特性常使决策过程难以解释。当AI做出错误或有争议的判断时,责任应由“单纯”的算法承担,还是背后“复杂”的设计者、部署者或监管者承担?这迫使基础软件开发也开始融入可解释性(XAI)工具。

三、基础软件开发的演进:在单纯与复杂间架桥

因此,现代人工智能基础软件开发已超越纯技术范畴,正在积极回应人性的复杂。其新趋势包括:

- 责任AI工具包集成:在开发框架中,逐渐融入公平性检测、偏见缓解、模型可解释性、数据溯源等工具,帮助开发者更早地察觉和应对伦理风险。

- 安全与鲁棒性优先:不仅防范传统软件漏洞,更专注于研究对抗性攻击的防御,确保AI系统在面对恶意输入时行为稳定可靠,避免被“复杂”的恶意利用。

- 开源与协作伦理:通过开源社区推动透明、共享的开发模式,让更多元的视角参与进来,共同审视和规范基础技术的方向,避免技术被少数利益集团垄断而加剧社会不公。

- 从“性能至上”到“价值对齐”:开发范式正在从一味追求更高的准确率、更低的延迟,转向思考如何让AI系统的目标与人类整体价值观、长期福祉相“对齐”。这要求基础软件提供更灵活的约束设计和价值函数建模能力。

###

人工智能基础软件开发,是一场在硅基的“单纯”与碳基的“复杂”之间进行的持续对话。我们打造的不仅是一套高效的计算工具,更是一个将人类智慧、价值观和责任感嵌入技术基座的接口。未来的方向,不是让AI变得像人一样复杂难测,而是通过更审慎、更包容、更负责任的基础软件开发,让这项强大的“单纯”技术,能够在复杂的人类社会中,稳健、公平且有益地运行。让技术之光照亮的是人性的良善,而非其阴影。

如若转载,请注明出处:http://www.wmvpau.com/product/45.html

更新时间:2026-03-01 23:26:01